Eine teure Nvidia-GPU in einem Online-Portal weckt das Interesse eines Gamers. Reddit klärt ihn auf: Sie kann viel, aber nichts für ihn.

Um was für eine Grafikkarte geht es hier? Im Subreddit „pcmasterrace“ fragt der Nutzer Squawk_1200 um Rat. Eine Grafikkarte namens „ThinkSystem NVIDIA L40“ verwirrt. Ihr Originalpreis laut Datenblatt liegt bei 30.000 US-Dollar, nun ist sie im Angebot für „nur“ knapp 6.000 US-Dollar.

Die Erklärung folgt rasch auf Reddit, es ist eine Server-GPU vom Typ AD102 (via Nvidia), also von der Hardware her eine RTX 4090 TI – das aktuelle Flaggschiff von Nvidia in etwas besser. Denn alle Chips, die auf Verbraucher-GPUs verbaut sind, entsprechen in der Regel nicht dem Maximum des Möglichen der jeweiligen Technikgeneration eines Herstellers. Serverchips sind deutlich näher dran und auch deshalb teurer.

Wozu ist eine L40 von Nvidia mit AD102-Chip da? Sie sitzt zusammen mit etlichen weiteren in voluminösen Serverchassis drin, um große Mengen an Bererechnungen parallel auszuführen. Das kann allerlei sein, zum Beispiel neurale Netzwerke, um Sprachmodelle zu trainieren, für zum Beispiel ChatGPT.

Sie setzt dafür auf die spezielle Architektur der Nvidia-GPUs mit CUDA- und Tensor-Kernen zu KI-Berechnung. Wir haben euch auf MeinMMO mehr zu dieser speziellen Art Hardware und wieso sie auch für Gamer relevant ist, in diesem Artikel erklärt.

Mächtig und doch für Gamer unnütz

Ist sie bei dem Preis schneller als eine RTX 4090? Ob diese oben verlinkte Grafikkarte beim immer noch stolzen, wenn auch reduzierten Preis von 6.000 US-Dollar, schneller ist als eine herkömmliche Top-GPU (ca. 2.000 US-Dollar) sei zunächst hinten angestellt. Zuerst stellt sich nämlich die Frage:

Kann ein interessierter Laie sie überhaupt bei sich zu Hause benutzen? Dem stehen laut den Experten auf Reddit sowie unserer Fachkenntnis nach nämlich drei potenzielle Stolpersteine im Weg:

- Hat die GPU Ausgänge für Monitore? Das ist nämlich keine Selbstverständlichkeit bei einer Workstation-GPU. Sie muss ja kein Bild rendern, nur Daten „wegrechnen“. In diesem Fall sind aber gleich mehrere Anschlüsse gegeben.

- Gibt es öffentlich zugängliche Treiber zur softwareseitigen Installation der Karte? Wahrscheinlich ja.

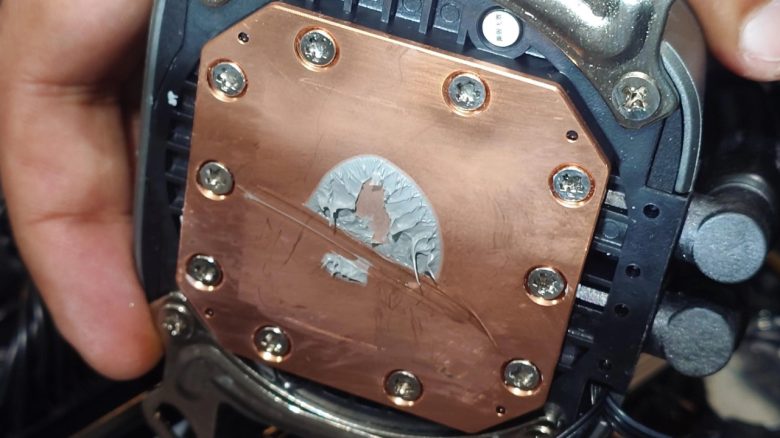

- Habt ihr ein Gehäuse mit einer potenten Kühleinrichtung? Das braucht es nämlich, da die GPU nur passiv gekühlt wird. Die Wärme muss extern abgeführt werden. Serverfarmen haben hierfür speziell designte, windtunnelartige Kanäle, um die Hitze effizient wegzublasen.

Ist sie denn nun wahrscheinlich schneller? Eventuell ja, aber das hinge stark von den Treibern sowie dem Spiel ab. Denn die Treiber wären nicht für Spiele optimiert, sondern für andere Anwendungszwecke und auch im Bestfall wäre der Zuwachs keinesfalls die etwa 4.000 US-Dollar wert, die rein für die Karte gegenüber einer RTX 4090 anfallen würden.

Nvidia Grafikkarten gehören zur Spitzenklasse der weltweit verwendeten Beschleuniger, um unter anderem moderne KIs wie Chatbots oder andere neurale Netzwerke zu trainieren. In obigen Artikel erfahrt ihr mehr dazu und welche Folgen, das in naher Zukunft nach sich ziehen könnte. Und eine interessante Entwicklung in der Politik haben wir hier für euch begleitet: Künstliche Intelligenz mischt die Politik auf: Ein Unternehmer wollte die Demokratie neu erfinden und scheiterte

Bitte lies unsere Kommentar-Regeln, bevor Du einen Kommentar verfasst.

Weiß einer wieviel momentan maximal möglich wäre wenn Geld bei der Grafikkarte keine Rolle spielen würde ? Sagen wir zB Elon Musk würde Nvidia 1 Milliarde Dollar geben für 1 Grafikkarte, die soll das maximal bestmögliche machen. Er fordert auf 16k Auflösung, 300 Fps auf maximale Grafik Qualität spielen zu können ohne das jemals unter die 300 FPS geht in jeden Spiel was aktuell erhältlich ist, wäre das möglich oder gibt es derzeit technische Hürden die selbst alles Geld der Welt nicht übersteigen können ?

Das Problem wäre der Speicher.

Wenn in 8k ein Steinchen schon ca. 1gb Größe an Textur hat, wäre das bei 18k rund 2.5gb.

Willst du überall diese hohe Qualität gaben und hast ca. 10.000 Objekte (weil die alle wichtig sind). Z.B. Hausbauteile, Waffenteile, Charactermodelle, Rüstungen, Vegetation, usw.

Kommt man schnell auf ca. 25.000 GB (25TB) Datenmenge.

Es gibt zwar schon Komprimierungen aber die bedeuten wieder Qualitätsverlust.

Das ist ein Problem bei hoher Auflösung was gerne vergessen wird!

Das gleiche Problem bei 4k Monitoren die dann 200hz und mehr haben. Das ist so unrealistisch, weil es schon schwierig ist in 4k auf die 120 fps zu kommen. Dabei muss noch Performance Probleme berücksichtigt werden. Etwa wenn Abfragen zu Spielmechaniken mehrmals abgefragt werden (überprüft usw.). Diverse Bugs Internetprobleme usw.

4k wird für die nächsten Jahre erstmal bleiben, dann erfolgt 8k und das wird wiederum noch länger bleiben… also je höher die Auflösung um so länger bleibt diese Technik.

Man schaue sich mal den Stromverbrauch eines 4k und 8k TV an. 8k Saugt mal fix bis zu 500 Watt aus der Dose. Nur mal so als Beispiel.

Dann muss das Kabel auch die Leistung können, darum sind so Hochleistungskabel immer so kurz. Bei 8k mit 120 hz wären das vielleicht 1-2 Meter reichweite?

Wenn schon 4k HDMI bei 3 Meter Leistung verliert.

Dazu kommt noch die Bitrate. Die meisten sind mit 8bit unterwegs. Bin vor paar Jahren auf 10 Bit umgestiegen, nächste wäre 12 Bit… so viele Farben müssen erstmal Berechnet werden und das braucht wieder mehr Leistung.

Theoretisch ist das möglich, weil mit der entsprechenden Kamera kann man das einfangen und umwandeln… aber was wäre der Sinn wenn das nur eine Person auf der Welt spielen kann und alle anderen es sich nicht leisten können?

Ich beschäftige mich damit seit längerem und das Thema ist so kompliziert weil es an vielen Ecken Probleme gibt.

8k oder 16k und mehr, dass lässt sich so einfach sagen aber dahinter Steckt so ein extrem großer Aufwand. Zu groß das dieser sich nicht lohnt.

Ab einem gewissen Punkt merkt man keinen Unterschied mehr.

Habe einen LG G4 Fernseher und wenn man darauf 4/8K Material abspiel ist das bereits so beeindruckend scharf das man sich eine Verbesserung davon kaum vorstellen kann. Also irgendwann ist der Punkt erreicht wo nicht mehr einen Unterschied macht.

Berücksichtigt man den Sitzabstand relativiert sich das ganze wieder.

Das ist der Grund warum 4k Filme über Streaming Dienste nur als 2k gestreamt werden. Habe hier auch 4k Filme und wenn ich die mit Bluray Vergleiche ist der Unterschied so gering… als ob man dafür beschissen wird das man für 4k Filme den doppelten Preis für vielleicht 10-20% bessere Qualität zahlt?

Alles klar danke für die lange Antwort